5 moduri de a elimina pagina de căutare Yandex sau Google - devaka SEO blog

Mulți webmasteri se va confrunta mai devreme sau mai târziu, necesitatea de a elimina din paginile motorului de căutare, care au ajuns acolo din greșeală, a încetat să mai fie relevante sunt duble sau conțin informații sensibile despre clienti (motivele pot fi diferite). Un exemplu luminos al acestei situații deja senzațional MegaFon, SMS-uri care oamenii sunt indexate Yandex, situația cu cumpărături on-line, în cazul în care pentru a găsi că a fost posibil să se găsească informațiile personale ale clienților și detaliile comenzilor acestora, situația cu băncile și companiile de transport, și așa mai departe ...

nu se va ocupa în acest articol, cauzele incidentelor descrise mai sus, și ia în considerare modul de a elimina inutile pagina Yandex sau Google. Implicația este că ei prenadlezhat site-ul dvs., în caz contrar este necesar să contactați proprietarul proprietății cu cererea corespunzătoare.

5 moduri de a elimina paginile din rezultatele căutării

1. Eroare 404

HTTP / 1.1 404 nu a fost găsit

În acest caz, va trebui să aștepte până când robotul din nou, nu va veni la această pagină. Uneori, este nevoie de o cantitate considerabilă de timp, în funcție de modul în care a ajuns în index.

Dacă pagina atunci când îl eliminați din căutare, trebuie să existe pe site-ul, această metodă nu este adecvată, este mai bine să utilizeze alte prezentate mai jos.

2. Fișierul robots.txt

O metodă foarte popular este de a închide prin indexarea secțiuni întregi sau pagini individuale este de a folosi rădăcina fișierului robots.txt. Există o mulțime de manuale, cum se configurează acest fișier. Aici vom prezenta doar câteva exemple.

Închide panoul secțiunea de administrare de la contactul său cu indicele de motoare de căutare:

User-agent: *

Disallow: / admin /

Inchide pagina special de la a fi indexate:

User-agent: *

Disallow: /my_emails.html # Pagina de închidere my_emails.html

Disallow: /search.php?q=* pagini # închidere de căutare

În cazul robots.txt trebuie, de asemenea, să aștepte pentru re-indexare, în timp ce robotul nu se va scoate de pe pagina de index sau o întreagă secțiune. În același timp, unele dintre paginile pot rămâne în index, în cazul în care motivul pentru obtinerea lor, au existat mai multe link-uri externe.

Această metodă este incomod de utilizat, dacă este necesar, îndepărtați diferitele pagini ale diferitelor secțiuni, în cazul în care este imposibil să elaboreze un model comun pentru directiva Disallow în robots.txt.

3. roboți Meta-tag

Aceasta este o alternativă la metoda anterioară, numai regula este stabilită în mod direct în tag-ul HTML a paginii, între etichetele

.Ușor de Meta tag-ul pe care le puteți adăuga toate paginile dorite (de la sistemul de control), care nu este de dorit să intre în indexul motorului de căutare, lăsând fișierul robots.txt în același timp simplă și directă. Dezavantajul acestei metode numai prin faptul că este dificil să pună în aplicare un site web dinamic utilizând un șablon header.tpl, în cazul în care nu există aptitudini speciale.

4. Titlurile X-Robots-Tag

Această metodă este folosită de sistemele de căutare străine, inclusiv Google, ca alternativă la metoda anterioară. În Yandex este nici o informație oficială cu privire la sprijinul http antet, dar este posibil, în viitorul apropiat va fi.

Esența utilizării sale este foarte similar cu o meta tag-ul roboți, cu excepția faptului că înregistrarea ar trebui să fie în http-headers, care nu sunt vizibile în codul paginii.

X-Robots-Tag: noindex, nofollow

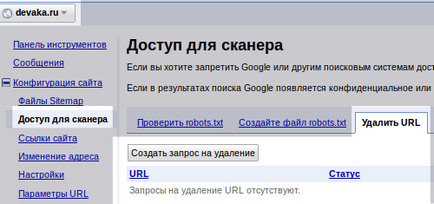

5. Înlăturarea manuală a webmasterului panoului

În cele din urmă, ultimul și cel mai rapid mod de a elimina paginile din index - este îndepărtarea lor manuală.

Singura cerință pentru îndepărtarea manuală a paginilor - acestea trebuie să fie acoperite prin metodele anterioare robotului (în robots.txt, meta tag-ul, sau eroare 404). Se observă că Google gestionează solicitările de eliminare în termen de câteva ore, Yandex trebuie să aștepte pentru următoarea actualizare. Utilizați această metodă dacă trebuie să eliminați urgent un număr mic de pagini de căutare.

Link-uri conexe

5 sfaturi pentru a crea o practică pagină 404

Îmbunătăți gradul de utilizare a paginilor 404th scade rata de respingere. Articolul oferă câteva sfaturi pentru a ajuta la a face pagina 404th mai eficientă.

Toate informațiile despre robots.txt

Pentru cei care încă nu s-au confruntat cu configurarea unui fișier robots.txt, resursa va fi un punct de plecare util. Se colectează o mulțime de exemple și alte informații utile.

Yandex: Utilizarea robots.txt

Exemple oficiale utilizați un fișier robots.txt de la Yandex. De asemenea, sunt prezentate de către Yandex a reprezentat linii directoare și alte sfaturi.

tag Google respectă Meta și Yandex pare să se concentreze nu vedea. Doar ieri a observat că Yandex căutare adăugat de două ori mai multe pagini decât sunt pe site. Sa dovedit că a ignorat ,și norul meu tag-ul primit în index.

Google spune (și experiența mea mica confirmă) că el pur și simplu nu indexează în două cazuri:

1) Meta tag

2) robots.txt + URL-ul de intrare în listă pentru a elimina webmasters.google (Configurare -> Acces Scanner -> Ștergere URL)

Și au îndepărtat foarte ușor. Google în câteva ore, dar întotdeauna păstrează o istorie a URL-ului. Yandex ... numai după ce acest articol am dat seama de ce era imposibil de îndepărtat - trebuie să așteptați câțiva ani, când a dat seama ce trebuie să facă.

Și cât de eficient închiderea paginilor de indexare roboți meta-tag, în timp ce nu prescrie o astfel de directivă care interzice fișierul robots.txt? La urma urmei, în cazul în care situația este inversată: în pagina de fișier robots.txt este închis, atunci tag-ul meta roboților este ignorat de SS.

natkalin. Da, un roboți aceasta este doar o recomandare pentru motorul de căutare, dar nu și o instrucțiune de a acționa, așa cum sa spus odată Mett Katts. Cu toate acestea, roboți le urmați cu atenție dacă, dimpotrivă, există un motiv convingător. Despre meta-tag-ul, am fi șters atât de pagini în Yandex. Au existat aproximativ 400, 5-7 actualizări a fost de 58, un timp foarte lung, deoarece robotul nu vine de multe ori pe paginile, dar meta tag-ul este încă în desfășurare ...

WMAs. dacă ștergeți un link către o pagină, motoarele de căutare nu raportează o eroare. In timp ce da, de ceva timp va fi plictisit 🙂

Un panou în Google webmasterul paginii sunt îndepărtate unul câte unul?) Dacă, să zicem, există un site în care versiunile lingvistice au fost planificate în proiectarea, care nu au fost traduse, iar mai târziu nu a făcut traducerea pentru ei. Se pare că o grămadă de pagini dublajului)) poate, desigur, închideți-le prin indexare mai târziu, dar aceste pagini vor fi în continuare în index este încă câteva luni și modul în care se poate copia această pagină nu este de dorit. Întrebarea este, există posibilitatea de a elimina toate panourile într-o anumită versiune lingvistică a paginii, sau încă mai au nevoie pentru a alege încet pe o singură pagină?) Vă mulțumesc)

Permiteți-mi să se clarifice. Poate cineva va ajuta la economisirea de timp. Dacă aveți directive robots.txt 2 'User-agent: Yandex' și 'User-Agent:', Yandex este în căutarea doar la secțiunea lor, ignorând general. Prin urmare, toate Disallow lor: se introduce secțiunea pentru Yandex sau ștergeți această secțiune și de a folosi directiva „pentru toți roboții. Am făcut înainte de a veni, a ucis-o jumătate de oră 🙂

Prompt site-ul, nefăcut, care a fost deja umplut la găzduirea, miracolul a fost în index, 145 pagini, aceste pagini fie goale, fie curba de text, sau un rip-off, dar a fost umplut cu scopul de a modifica.

Cum să fie în această situație? Ar trebui să eliminați toate paginile cu indexul? Sau, puteți rezolva rapid pagina principală? Redenumirea multe pagini, ce se va întâmpla cu paginile vechi sunt indexate? Și toate acestea gunoi în index, va afecta ratingul la o optimizare viitoare?

Aș fi foarte recunoscător pentru un răspuns clar!

Dacă aș fi fost în locul site-ul dvs. de indexare închis în robots.txt și să-l elimina complet din index prin intermediul panoului pentru webmasteri. După eliberarea tuturor deja să fie deschis și indexare va merge din nou.

Nu există sancțiuni nu ar trebui să fie în oricare dintre cazurile selectate de tine. Și când vorbim despre clasament, ne referim la rating-ul de documente utile, doar gunoi nu vor fi afișate.

Am șterge profilul meu de pe site-ul, dar informațiile mele personale, cum ar fi: numele, data nașterii, fotografia încă vizibile în căutarea Google. Este posibil, în acest caz, creați un 404 dacă nu dețin un site? Am nevoie pentru a elimina informațiile într-un fel, dar nu știu cum. Deja am mers la un serviciu Google, am descris problema mea. Ei au spus că este necesar să se facă referire la site-ul proprietarului / administratorului. Am trimis o mulțime de scrisori, dar tăcerea.

Catherine, informația nu are o caracteristică de clonare, care curata, apoi întotdeauna. Dacă nu aveți acces la aceste site-uri în cazul în care doriți să le ștergeți informațiile, este puțin probabil ca ai ceva să funcționeze, trebuie să negocieze cu proprietarii. Sau dacă cumva încalcă legea, este de a scrie o plângere cu gazda. 404 pe site-ul altcuiva poti face nu numai admin lor.

Petru, este, probabil, o coincidență. Undeva în altă parte greșit. Verificați robots.txt, meta-roboți și antetele HTTP.

meta-roboți verificat - totul este bine, antete http - de asemenea, bun.

Într-adevăr, atunci când au luat site-ul, fișierul robots.txt nu a fost Yandex directivă. Am adăugat că pentru a verifica disponibilitatea paginilor, tot executate corect.

Este posibil: Yandex a văzut reînnoit Roboți și a decis, ca să spunem așa, pentru a începe de la zero?